“챗GPT는 무언가를 잘 흉내내는 도구”

사람? AI? 작성자 예측 불가능

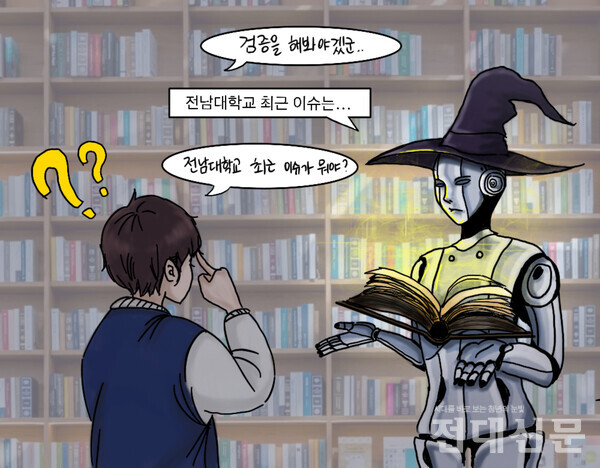

최신 이슈는 반영 어려워

챗GPT, 넌 누구니?

2015년에 설립한 인공지능 연구소인 OpenAI가 챗GPT를 출시하고 서비스 개시 5일 만에 가입자 100만 명을 돌파했다. 지난해 11월 출시된 GPT 3.5는 사회적으로도 큰 화제가 됐다. 챗GPT는 대화형 컴퓨터 프로그램인 Chatbot(챗봇)과 자연어를 처리하는 인공지능 GPT(Generative Pre-trained Transformer)가 합쳐진 대화 전문 인공지능이다.

GPT는 단어들의 연관관계를 살피고 다음에 올 가장 적절한 단어를 찾아내는 생성 모델이다. 질문을 입력하면 사전에 입력된 정보들 중 확률적으로 가장 연관성이 높은 단어가 답으로 나오는 것이다. 예를 들어 ‘사랑과 00에서 00안에 들어갈 단어는 무엇이냐’고 물었을 때, 기존에 어떤 언어 모델이 있느냐에 따라 00이 정해진다. 이전에 드라마에 대한 정보를 학습했다면 ‘사랑과 전쟁’이라 답할 확률이 높고 아름다움에 대한 정보를 입력했다면 ‘사랑과 평화’라는 답을 할 확률이 높다.

이러한 GPT는 API와 결합되어 사용자의 질문에 답을 하게끔 도움을 준다. API는 또 다른 학습모델로, 글을 작성하는 API, 키워드를 찾는 API, 요약을 하는 API 등 다양한 모델이 있다. 사용자가 어떤 질문을 하느냐에 따라 필요한 API가 연결되어 답을 도출한다.

챗GPT는 기본적으로 자연어를 처리하는 인공지능이다. 실제로 김경백 인공지능융합학과 교수가 챗GPT에게 수능 영어 지문을 주고 문제 풀이를 요청하자 몇 초 만에 정답과 이유를 도출해냈지만 일부 수학 문제는 풀지 못하고 영어와 확연한 성적 차이를 보였다. 김 교수는 “챗GPT가 영어를 기반으로 학습된 인공지능이기에 영어에 대한 이해력은 아주 높다”면서도 “국어의 경우 영어로 번역을 해서 답을 도출하고 다시 국어로 번역을 해서 우리에게 보여주게 되는데, 특히 고전 국어 등 복잡한 국어는 번역의 한계로 엉뚱한 답변을 내놓을 가능성이 높다”고 말했다. 또한 “수학의 경우 자연어가 아니기 때문에 이론적 배경과 수학적 알고리즘을 잘 이해하지 못해 문제 푸는 능력이 떨어진다”고 말했다.

적은 정보로 긴 글도 뚝딱

챗GPT의 특징 중 하나는 ‘퓨샷러닝(few-shot learning)’의 학습 방식을 사용한다는 것이다. 퓨샷러닝은 인공지능을 학습시키는 러닝 기법으로 적은 양의 데이터만 학습해도 스스로 일반화해서 새로운 데이터를 만들어내는 기술이다. 챗GPT를 이용할 때도 약간의 정보를 주면 그 정보를 기반으로 관련된 문장을 쓴다. 정보가 자세하면 자세할수록 더 다양하고 복잡한 글이 작성된다. 논리적인 글뿐 아니라 소설이나 시 같은 문학적인 글도 생성 가능하다.

그렇다 보니 일각에서는 인공지능의 대절 및 표절 가능성도 제기되고 있다. 특히 챗GPT를 저자로 인정할 수 있는지에 대해 국제 학술지 ‘네이처’는 챗GPT를 포함한 대화형 인공지능을 논문 저자로 인정하지 않겠다는 가이드라인을 제시했고 ‘사이언스’도 챗GPT와 같은 인공지능 도구를 활용한 연구성과는 인정할 수 없다는 지침을 발표했다. 김 교수는 “작성된 글만 봐서는 사람이 썼는지 인공지능이 썼는지 구별이 불가능한 수준”이라고 말했다.

챗GPT는 “과거에 사는 아주 똑똑한 사람”

그러면 이제 과제와 시험은 전부 챗GPT에게 맡기고 우리는 놀아도 되는 것일까? 문제는 챗GPT가 제시한 답변이 100% 정답일 보장이 없다는 것이다. 김 교수는 “챗GPT는 엄청나게 많은 것을 알고 있으며 무언가를 잘 흉내 내는 도구”라고 말했다. ‘이 주제에 대하여 최신 연구 논문을 검색해 줘’라고 챗GPT에게 요청을 하면 검색을 하는 것이 아닌, 검색을 한 것처럼 문장을 만들 수도 있다.

챗GPT는 이미 학습된 보편적인 내용을 바탕으로 새로운 내용을 작성한다. 확률적으로 답변을 하기 때문에 가장 많이 나온 내용 즉, 뻔한 내용의 답이 나올 가능성도 높다. 그렇다 보니 세분화되거나 한 분야에 특화된 질문을 던졌을 경우 제대로 된 답변을 얻지 못할 경우가 많다.

또한 챗GPT는 최신 이슈를 잘 반영하지 못한다. 앞서 설명한 것처럼 챗GPT는 ‘Pre-trained’ 즉, 사전에 학습을 한 언어 모델이기 때문에 많은 정보를 가지고 있음에도 불구하고 이미 그 정보들은 과거에 얻었던 정보들인 것이다. 지난 15일 출시된 GPT 4도 2021년 9월까지의 데이터를 기반으로 하고 있다. 새로운 데이터를 학습시키려면 오랜 시간이 걸려, 앞으로의 인공지능은 최신 자료를 얼마나 빨리 학습시킬 수 있는지가 관건이다.

김 교수는 이러한 특성을 지닌 챗GPT를 “과거에 사는 아주 똑똑한 사람”이라고 표현했다. 과거에 사는 사람이라면 아무리 많은 것을 아는 똑똑한 사람이라 하더라도 현재의 상황까진 알 수 없다. 그의 답은 최신성이 부족한, 과거의 지식들로만 도출해낸 결론이다. 김 교수는 “챗GPT가 답한 내용이 진짜 정확한지 아닌지는 결국 그 내용을 공부한 사람만 알 수 있다”며 “학생들이 주도적으로 검증할 수 있는 역량을 갖춰야 한다”고 말했다.

고려대, “챗GPT 활용 권리 보장”

웬만한 사람보다 빠르고 완성도 있게 글을 쓰는 인공지능 덕에 대학가에서는 챗GPT에 대한 논의가 활발히 이루어지고 있다. 학생들은 이미 곳곳에 챗GPT를 활용하고 있다. 윤현구 문화인류고고학과 조교는 “학사 업무 중 폐강제외요청서와 사업계획서 작성을 할 때 사용한 적이 있다”며 “챗GPT가 답한 그대로 쓸 순 없었지만 어느 정도 골자는 잡혀 도움이 되었다”고 말했다. 이어 “글의 구조를 짜주는 것만으로도 충분히 사용할 가치가 있다”며 “어떻게 하면 더 활용할 수 있는지 배우고 싶다”고 말했다.

우리 대학에서도 지난달 15일 정성택 총장을 비롯한 핵심 보직교수들이 대학본부에서 챗GPT에 대한 설명회를 가졌다. 발제에 나섰던 김 교수는 “교수들이 챗GPT에 대해 파악을 할 수 있도록 설명을 했다”며 “이미 나온 기술의 발전을 막을 순 없으니 우리 대학에서 어떻게 쓸지 방향이 정해져야 할 것 같다”고 말했다.

다른 대학들도 챗GPT 사용을 무조건 막기보단 활용 가이드라인을 제시하고 있다. 미국의 예일대는 AI 도구를 제한하는 것이 현실적으로 불가능하다며 강의 계획서에 챗GPT 활용 가능 여부를 명시하도록 했다. 고려대학교는 국내 대학 최초로 표절과 대필에 대응하여 ‘챗GPT 활용 가이드라인’을 마련해 전체 교수들에게 배포한 상황이다. “학습 효과를 높이고 긍정적인 교육 경험을 하기 위해서 챗GPT 등을 활용할 수 있는 권리는 보장해야 한다”면서도 챗GPT가 대신하기 어려운 인터뷰 등의 과제를 학생들에게 제시하라고 교수들에게 권고하는 게 가이드라인의 주된 내용이다.

김 교수는 “지금은 사람들이 챗GPT에 대해 알아가고 있는 과정이기 때문에 익숙해지는 시간이 필요하다고 생각한다”며 “소프트웨어 중심대학 사업 단장으로서 학생들이 인공지능 활용법에 대해 서로 공유하는 행사들도 진행을 해보려 고민 중이다”고 말했다.